1.Introdução

Na visão de Rui Santiago ao se tratar de qualidade no ensino superior, “não há uma definição razoável; o que se detecta são critérios genéricos e linearizantes, entre os quais a satisfação do aluno justifica a etiqueta da qualidade”. Portanto, ao se verificar a diversidade de modelos e missões institucionais, não dá para confundir qualidade, tão somente, com base em critério do mercado e ou um corpo docente de destaque e prestígio (Santiago, 1999). Como Reisberg adverte que a qualidade, em grande medida, “depende de quem vê e as diferentes perspectivas responderão às diferentes medidas." Logo, o debate aqui se dá em torno da perspectiva da qualidade do processo avaliativo implementado na abrangência do SINAES, que, como outras políticas educacionais , vem apresentando contradições desveladas pela categoria constituição versus desconstituição, o que pode estar comprometendo o apregoado conceito evasivo de “qualidade” esperado das instituições (Reisberg, 2011). A razão desta parte levantada é a de que a base fundante do SINAES, que foi concebida sob o pilar da regulação e da emancipação, na prática enveredou por caminho único; ou seja, essencialmente regulatório, como já denunciaram inúmeros estudos. Segundo Denise Leite (Leite, 2005), a regulação tem servido para identificar problemas de produtividade e pontos competitivos” e Dias Sobrinho (2008, p. 821), alerta que o SINAES deixou de produzir significados; questionamentos sobre a pertinência e a relevância científica e social, reduziu-se a medida de controle”. Sob tais argumentos é notória a incompletude do uso de dados, eminentes, quantitativos para determinar a qualidade das instituições, em face da complexidade de elementos políticos, sociais, e da cultura institucional imbricados na filosofia, missão e diretrizes pedagógicas de cada instituição. Longe disso, as abordagens qualitativas que seguem as “regras metodológicas derivadas das ciências naturais, como as de validade interna, validade externa e fidedignidade”, conforme Paula e Pereira (Paula & Sivieri-Pereira, 2015), podem oferecer elementos para o estudo de diferentes fenômenos articulados e orientados para uma visão crítica, relacional, de complementaridade, similaridade e totalidade, “capaz de incentivar as instituições a se tornarem organizações que se autodesenvolvem, pois procuram, continuamente, a melhoria de seus processos”(Dill, 1997). O modelo SINAES, por vezes leva a um uso perverso dos instrumentos de regulação, pois segundo Félix, Bertolin & Polidori, (2017, p. 19), como política de avaliação educacional em larga escala, sendo, pois, o modelo dominante que se desenvolve um pouco em toda a parte e, que está a segmentar a qualidade da educação superior entre produtos e processos, o que precisa ser revisado, se não pelo marco oficial, pelo caráter autonômico que consta no artigo 207 da Constituição Federal de 1988 (BRASIL, 1988). De acordo com Morosini, “não dá para viver só de produtos, até porque as condições que fizeram com que tal produto fosse obtido, está no processo” (Morosini, 1997). Sobre regulação, Hood (Hood, 2004) sinaliza que há três condições que são usadas para regular-se atividades e serviços de Estado; ou seja, “o controle, através de diretrizes do governo; a competição através da valorização de relações do mercado e a influência horizontal de pares, manifestada através de processos de autorregulação". O caso em análise se refere ao “controle, através de diretrizes do governo”, pois, na visão de Vehrine (Verhine, 2015), “tal regulação é caracterizada pela aplicação e acompanhamento de regras e normas de natureza obrigatória que são estabelecidas e fiscalizadas por uma agência pública legalmente constituída para tal fim”. Muitas questões perpassam e, estão envolvidas nesta discussão, contudo pode-se adiantar algumas situações e circunstâncias contextuais como:

“As políticas públicas de avaliação têm estimulado a competição interinstitucional, quando assumem a lógica da ideologia de mercado, cuja ênfase é posta nos produtos da educação. E, para ter sucesso na competição mercadológica, usam diferentes estratégias para que o resultado dos exames seja alvissareiro para a instituição, como solução para evitar o desconforto” (Cappelletti, 2015).

Dentre estas e, outras situações é que se constata o desequilíbrio entre a intenção e a prática, por onde as regras do jogo foram alteradas e, parte da equipe concentrou-se na competição, dando ao SINAES um viés eminentemente técnico, burocrático e quantitativo, cuja direção fere a “responsabilidade social e a autonomia das universidades” em realce na Lei 10.861/ 2004. No tocante a processos emancipatórios de avaliação, Denise Leite (Leite, 2005) alerta ser “um modelo centrado nos participantes, que, ainda, mantém a figura do especialista como condutor do processo” e para Ana Maria Saul esse formato tem de ser reflexionado a partir de questões, como: “Quem nós somos? O que é o programa? Quais as críticas que se fazem? Quais os compromissos? Qual a proposta?” (Saul, 2001). Tais elementos dão conta de levar as IES a pensar, autonomamente e de modo participativo, especialmente na construção de um processo de autoavaliação próprios e, principalmente, refletir sobre os seus resultados e a sua utilidade; a tendência é valorizar as instituições através de informações mais qualitativas e não os sistemas, como consta no art. 3º, Inciso VI, da Lei do SINAES.

“avaliação das instituições de educação superior terá por objetivo identificar o seu perfil e o significado de sua atuação, por meio de suas atividades, cursos, programas, projetos e setores, considerando as diferentes dimensões institucionais, dentre elas obrigatoriamente o seguinte: A organização e gestão da instituição, especialmente o funcionamento e representatividade dos colegiados, sua independência e autonomia na relação com a mantenedora, e a participação dos segmentos da comunidade universitária nos processos decisórios” (Brasil, 2004).

É importante insistir nessa dupla direção; ou seja, no resgate da avaliação da educação superior em dois pilares como advoga o projeto original do SINAES. Parece-nos que o exercício de um dos eixos, bem ou mal, através da investigação quantitativa está resolvido, por outro lado, falta colocar em prática o artigo acima citado, ou seja, dar voz e valorizar a comunidade acadêmica visando à democratização da universidade pública, o que só poderá ser feito com a soma das subjetividades dos indivíduos e dos grupos por meio de dados qualitativos.

2.Metodologia

2.1 O paradigma e opção metodológica

A partir da constatação de que era necessário implementar uma autoavaliação institucional que pudesse ultrapassar a lacuna de suporte para a autonomia do acompanhamento da qualidade dos cursos, foi decidido construir esse sistema de avaliação interna institucional, feita à medida e de forma participativa. Sobre participação, autonomia, reatividade e antecipação em avaliação na educação superior, Oliveira, Silva & Félix (2017, p. 46) defendem a ruptura com “a lógica de que só se organiza a casa quando o governo realiza visitas”; a propositiva é ser independente de guiões, prazos e roteiros governamentais e estabelecer um equilíbrio entre a regulação e a emancipação. É deste ponto que surgiu a intenção de elaborar um Programa de Avaliação Institucional, contendo dez subprojetos de pesquisa que versaram sobre dimensões qualitativas integrantes do Projeto Pedagógico dos Cursos, indicadas, previamente, pela comunidade dentre as quais, a dimensão “estágios académicos”; com a intenção de produzir um conhecimento consistente, capaz de provocar mudanças em estruturas cristalizadas, propondo indicadores de qualidade, com vista à melhoria da qualidade. Félix, Pinho, Bastos & Bertolin (2018). Para tal, foi organizado uma subcomissão composta por: a) um professor-orientador de cada curso (5); b) um especialista em avaliação; c) um representante externo e d) um estudante-estagiário. Estas pessoas, após análise de um inquérito exploratório, elaboraram dois questionários específicos: a) para os estudantes-estagiários e b) aos gestores das instituições. Pretende-se capturar a percepção destes dois tipos de participantes, não esquecendo que os resultados obtidos no estudo de caso “não podem ser generalizados e têm como objetivo compreender em profundidade o “como” e os “porquês” dessa entidade particular” (Ponte, 2006). O uso de questionários fundamentou-se na praticidade e na eficiência da execução de ferramentas disponíveis, capazes de dar retorno rápido e satisfatório em relação à coleta, a quantidade, o acesso e o armazenamento em banco de dados a serem manipulados em tempo real. Nisso estabelecemos um diálogo entre a universidade e as escolas básicas, comparamos o ponto de vista de atores, diretamente, envolvidos, mas não raras vezes, diametralmente opostas. As estratégias de interlocução com os participantes foram alinhadas com os objetivos da avaliação e os argumentos teóricos (Bardin, 2004; Harvey & Green, 1993; Hood, 2004; Leite, 2005; Morosini, 1997; Verhine, 2015; Yin, 2003), cujas lógicas, jogaram luz na direção da problemática relacionada à avaliação dos estágios. Conforme Denise Leite, os princípios que sustentam a avaliação participativa vêm da democracia forte, porque é “entendida como regime de governo que se caracteriza pela formação de uma comunidade capaz de resolver suas questões e conflitos através da participação, de autocrítica e autorregulação” (Leite, 2005). Assim, ancoradas no paradigma da Avaliação Institucional Participativa (IAP), procuramos abarcar o escopo da pesquisa, em oposição aos modelos prontos, fixos e formatados na e da quantificação implementada pelo SINAES.

2.2 Elaboração dos instrumentos

A partir de reuniões com a participação de todos os professores/orientadores e coordenadores de cursos, estudantes-estagiários e representantes das instituições em convênio, foi decidido constituir uma subcomissão, específica para os estágios académicos, formada por oito integrantes; ou seja, um professor de cada curso (5 professores de cada um dos 5 cursos), um professor especialista em avaliação, um representante externo e um representante discente, para a elaboração dos instrumentos que iriam compor a avaliação. Foi feita, ainda, uma sondagem de opinião sobre quais os assuntos, os meios e instrumentos que deveriam ser considerados. Deste processo participativo, resultou a elaboração de dois questionários:

Instrumento de Avaliação e Autoavaliação dos Estudantes-estagiários (IA-4 A) e

Instrumento de Avaliação das Instituições em convênio (IA-4 B).

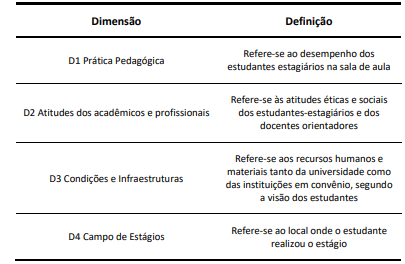

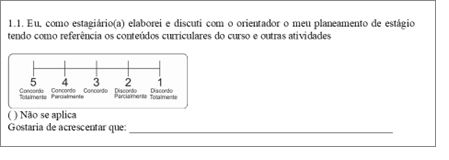

Pretende-se recolher dados do ponto de vista dos estudantes-estagiários, segundo quatro dimensões (ver Tabela 1).

O instrumento dos estudantes/estagiários abarca as quatro dimensões; Prática pedagógica; Atitudes acadêmicos-profissionais; Condições e infraestrutura e Campo de estágio. Cada uma destas dimensões abarca três questões. Por exemplo, na pergunta 1.1. é pedido ao estagiário que classifique a sua resposta numa escala likert de 1 a 5 pontos. Para além disso, na última linha é possível que o estagiário possa acrescentar algum comentário do assunto (ver Figura 1).

2.3 Recolha e análise de dados

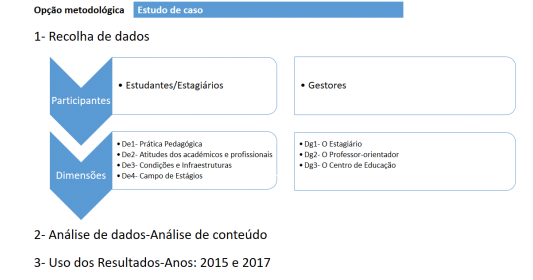

Após a elaboração dos questionários, estes foram sujeitos a pré-teste, com um número reduzido de participantes e posteriormente procedeu-se a pequenos ajustes. Este artigo foca no estudo de caso, correspondente aos anos de 2015 e 2017, explicitando as etapas de recolha, análise de dados e uso dos resultados (ver Figura 2). De notar que enquanto o instrumento para os estudantes/estagiários abarcam quatro dimensões, o instrumento para os gestores abarcam três primeiras dimensões.

A recolha dos dados foi feita através da possibilidade de preenchimento online dos questionários, durante um período de 30 dias. Por vezes, devido à instabilidade da internet em muitas escolas e por os gestores das escolas serem exteriores ao sistema web da instituição universitária houve a possibilidade de preenchimento manual. De notar as próprias estagiárias foram agentes ativos na entrega e recolha dos instrumentos até o prazo estipulado, junto aos gestores. Em 2015, houve a participação de 61 escolas e em 2017, esta participação subiu para 73. O resultado final da avaliação nestes dois períodos gerou dois tipos de dados: quantitativos e qualitativos. A riqueza dos dados qualitativos ajudou a complementar o uso de dados quantitativos. Lembramos que este artigo é um recorte destas avaliações, onde se procura focar nos resultados qualitativos da investigação. Como antes fora anunciado, o conjunto de informações coletadas foi examinado por meio do método Análise de conteúdo, que se constitui em um conjunto apropriado de técnicas a serem usadas na análise de dados qualitativos (Bardin, 2004; Costa & Amado, 2018). Tal permitiu aliar os argumentos da nossa construção teórica, os instrumentos construídos e utilizados, alinhar e complementar resultados com o modelo de avaliação do SINAES, possibilitando conjecturas sobre o nível de qualidade dos estágios acadêmicos da unidade de ensino investigada.

3.Resultados e discussões

Na sequência, apresentamos os resultados gerais da participação dos estagiários e das instituições em convênio; subsequente, o resultado da pesquisa qualitativa para a unidade de ensino (5 cursos); seguida da pesquisa qualitativa das instituições em convênio e, de imediato a cada item, apresentamos a discussão dos dados.

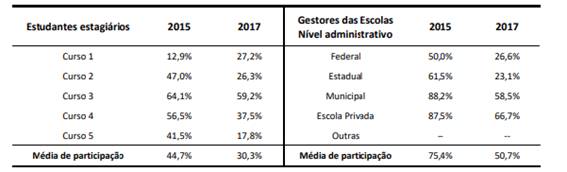

A participação geral dos estudantes no ano de 2015 obteve uma média de 44,7% e em 2017 teve um declínio, perfazendo 30,3%. Integraram a pesquisa apenas os Cursos que alcançaram no mínimo 20% de frequência em cada ano. Como observa-se na Tabela 2, apenas dois cursos, em anos diferentes, ficaram impossibilitados de participar, contudo, ambos tiveram a oportunidade de participar em pelo menos uma edição.

No caso das instituições em convênios de diferentes esferas administrativas, onde os estágios foram ofertados, obtivemos em 2015 um percentual de 75,4% e, no ano de 2017, totalizou 50,7% de participação. A Tabela 2 explicita a intensidade da participação dos estudantes/estagiários por curso e das escolas por esfera administrativa. A maior participação dos estudantes/estagiários foi a do curso 3, tanto na avaliação de 2015 como de 2017. Por outro lado, o curso 1 teve a menor participação em 2015. Também foi nas escolas onde estes estudantes fizeram os seus estágios que os gestores dessas escolas menos participaram (em 2017 com 26,6% e em 2015 com 50%). Tal requer seguir esta pista para saber das razões desta fraca participação.

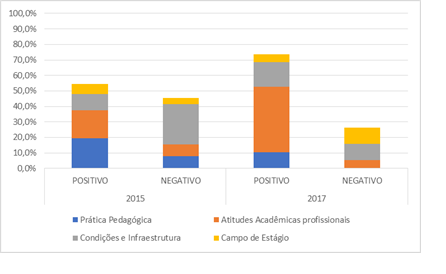

Pela variação dos índices atingidos pelos dois segmentos, observa-se que a participação variou, muito mais, no sentido crescente, até por parte da consciência de que estavam construindo algo a partir da sua interferência direta e, não por um produto formal, de fora para dentro da universidade. Destaca-se que a forte participação das instituições foi motivada pelo sentimento de valorização e interesse de trocas com a agência formadora, pois, “a nossa escola sentiu-se envaidecida e está de portas abertas, na expectativa dos estagiários para o próximo ano (2017 _64). Acerca do tratamento das questões qualitativas de ambos os questionários, empregou-se a técnica Análise de conteúdo (Bardin, 2004), com o apoio do software NVIVO 11, as mensagens foram lidas e categorizadas em negativas e ou positivas, ou seja, ao ler o texto procurou-se não só identificar as unidades de texto que se referiam a cada dimensão, mas também se esta referência era positiva ou negativa. O conjunto de todas estas unidades constituem as categorias de análise. No total foram classificados 619 questionários preenchidos em 2015 e 460 em 2017. Na Figura 3 são apresentados a distribuição das frequências (positivas e negativas) nestas 4 dimensões, para o segmento estudante-estagiário

Segundo esses achados, podemos verificar de um modo geral que as respostas tiveram um caráter positivo; o que se alternou entre as dimensões “Prática pedagógica” (2015) e “Atitudes académicas- profissionais” (2017), o que refletiu o olhar dos estagiários para a própria ação na primeira e, na segunda, deslocaram- no para o orientador e a instituição onde exerceram a prática, o que é natural num processo de autoanálise. Por outro, a visão dos estudantes aponta para a necessidade de melhoria da qualidade do processo do estágio, notadamente, em categorias estratégicas que dependem da prática dos gestores das instituições envolvidas; uma vez que a dimensão “Condições e infraestrutura” da unidade de ensino necessita de melhorias, na ampliação de espaço, como também, no papel de formação das instituições/escolas envolvidas, configurado na dimensão “Campo de estágio”. Os excertos selecionados a seguir expostos validam tais necessidades.

“Acredito que deveríamos ter um atendimento mais individualizado, com uma sala apropriada e destinada para tal, a cada orientação tem de achar sala disponível” (2015 _ 191). “Muitas vezes senti que esse intercâmbio não é entendido pela professora da classe e até pela escola, fiquei sozinha com a turma, muitas vezes, quando mais precisava de acompanhamento (R2017_66).

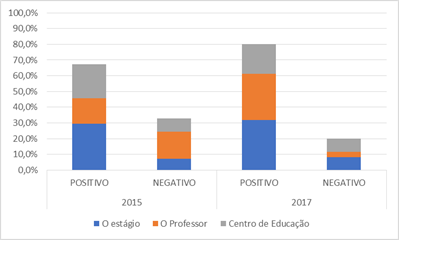

Em relação à restituição dos apontamentos qualitativos dos gestores das Instituições em convênio, achamos 309 mensagens em 2015 e 220 em 2017. A Figura 4 apresenta o resultado da frequência de respostas por categoria e ano desvelada no estudo para este público.

A partir do substrato de tais resultados ratificam-se que, pela ótica dos gestores das instituições, também, prevaleceu a percepção desta avaliação como um elemento positivo, por onde, marcadamente, sobressaiu-se pela dimensão “Estágio”; ou seja, a importância de ter estagiárias na escola, nos dois anos analisados, isso talvez tenha explicação no vínculo da extensão e da atualização através de “novidades didáticas, pois segundo uma manifestação, “trouxeram novas experiências contribuindo, sobremaneira, no processo pedagógico” (R2017_29), como também, parece-nos que representou a oportunidade de as escolas terem pessoal para acompanhar e, até substituir professores, visto que segundo a fala um de gestor “precisamos de atividades reservas para os momentos necessários” (R205_17). Em objeção ao segmento dos estagiários, os responsáveis pelas instituições reconheceram, em duas dimensões, a responsabilidade pelo comprometimento da qualidade dos estágios; ou seja, as dimensões o “professor-orientador” e o “Centro de Educação”. Pelas críticas formuladas, ficou claro não ser uma regra geral, os professores-orientadores conhecerem o Projeto pedagógico das escolas e acompanhar, regularmente, os estagiários, como também, o descontentamento das escolas, com o fato de a unidade de ensino não dispor de uma Comissão central responsável para sanar casos irresolvidos pelos professores-orientadores, até de cunho psicológico, segundo as escolas. Os trechos abaixo, realçam a extensão do problema:

Com base nestes resultados foram tomadas medidas concretas, como por exemplo: criação da comissão central de estágios; criação de sala específica para orientações; reuniões com os gestores das escolas no início, meio e fim do processo de orientação e de avaliação. Os orientadores passam a trabalhar junto com as escolas para um plano dos estágios. Verificou-se ainda um incremento do acompanhamento, por parte da comissão central de estágios aos docentes-orientadores nas escolas.

4.Considerações Finais

Ao término das atividades desta pesquisa que objetivou conhecer o nível da qualidade dos estágios acadêmicos, julgamos ser digno o compartilhamento dessa experiência, que reforçou a nossa convicção da autoavaliação institucional como uma ferramenta de gestão valiosa. Saber captar a percepção dos principais interessados, através dos métodos qualitativos, é uma competência a desenvolver institucionalmente. A complementaridade desta autoavaliação com a avaliação do SINAES enriquece o que se pode obter sobre o significado de qualidade no ensino superior. As instituições devem ter muita cautela ao conformar-se em aplicar as avaliações de natureza quantitativa, limitadas para abranger a realidade. Para além de mensurar as questões relativas ao espaço físico, desempenho quantitativo dos alunos e cursos, titulação docente entre outros insumos requeridos pela avaliação estatal, o elemento fundamental é seguir a norma jurídica na sua forma constituída, ou seja, atentar, especialmente, para o artigo 1º da Lei 10.861/2004, que fala em “respeito a diversidade, valores democráticos, afirmação da autonomia e identidade institucional,” foi na gênese desse item que a unidade de ensino escutou a sua comunidade, retirou indicadores de qualidade e realizou devolutivas como poucos espaços fazem. Para responder à questão de pesquisa, a metodologia qualitativa foi um facilitador para a construção de indicadores nesta Avaliação Institucional Participativa (AIP) (Leite & Nunes, 2009). A evolução de avaliação sumativa para a avaliação formativa, feita de modo participativo, pode ser assim acelerada e melhorada através da recolha de dados qualitativos. Os indicadores qualitativos são de elevada riqueza informativa mas exigem formação na competência de saber recolher, analisar e usar os seus resultados (Leite et al., 2020; Leite & Polidori, 2021). Foi em razão do uso e da utilidade da base qualitativa, neste estudo, que o processo foi capaz de levar atores do cotidiano a falarem sobre a instituição, os professores, as escolas; por mais que isso pareça simples ou evidente, não é comum. O valor pedagógico desse processo está na descoberta de que, além das barreiras físicas, é preciso melhorar a qualidade da prática pedagógica dos orientadores, as atitudes académicas dos estagiários e o comprometimento das instituições que recebem os estagiários, como, também, o acompanhamento do professor regente da classe na prática. Um ponto forte foi a participação das instituições em convénio, isso consolidou a relação entre a universidade e a escola básica para além de processos formais; obter mais que 50% de adesão no ciclo demonstra o interesse em querer contribuir para a melhoria da formação docente. Estes resultados de 2015 e 2017 serviram para aperfeiçoar a qualidade destes cursos e, tiveram continuidade nas avaliações de 2019 e 2021. Os resultados foram divulgados pela comunidade e os gestores com base nestes resultados procuraram realizar mudanças mais direcionadas às demandas apontadas na avaliação, como a destinação de uma sala adequada para as orientações e materiais didáticos aos orientadores. Saber da importância da presença da universidade nas escolas e descobrirmos os pontos que precisam ser reavaliados para o preparo e o comprometimento da formação são elementos de partida que ensejam o caminho da mudança. Depreende-se, pois, que o processo de estudo qualitativo desenvolvido neste estudo de caso participativo ocasionou excepcionais frutos ao grupo envolvido em torno da prática da investigação e do objetivo da pesquisa. O fruto inicial foram as práticas pessoal e coletiva; seguida da atividade de um arcabouço concreto e, por último, o arranjo desta atividade. A avaliação do SINAES tem evoluído e para além de fazer parte de uma avaliação institucional ela está ligada à melhoria da qualidade da educação Superior (do Nascimento de Paula, 2019; Leite et al., 2020; Manatos et al., 2017) Conclui-se que a implementação desta avaliação inovadora e pioneira na instituição é possível ser feita para melhor conhecer a instituição como para complementar a avaliação obrigatória do SINAES. O desafio passa por saber usar tanto os indicadores e resultados quantitativos como qualitativos e conseguir integrar a informação para provocar a mudança desejada de melhoria contínua, que advém não só de um diagnóstico do passado mas de uma autoavaliação participativa e integradora (Félix et al., 2016; Leite & Nunes, 2009; Shavelson, 2018; Zeledon-Ruiz & Araya-Vargas, 2019). Em suma, a metodologia qualitativa possibilita não só um diagnóstico a partir da participação ativa dos principais interessados na avaliação, tendo um impacto na qualidade da formação dos futuros professores, constituindo-se, assim, num indicador qualitativo de mudanças de modo geral e, um facilitador de implementação de medidas a tomar em pontos específicos nos cursos selecionados. Deste modo, a tomada de decisão é suportada na evidência que também emerge de dados qualitativos.